Flash 2.0 — полная победа Google над DeepSeek и OpenAI

20 января 2025 года, когда компания DeepSeek выпустила R1, свою недорогую модель рассуждений, я подумал, что революция в области ИИ достигла своего пика. Никогда не был так впечатлен.

Однако OpenAI и Google отреагировали на это событие с беспрецедентной скоростью.

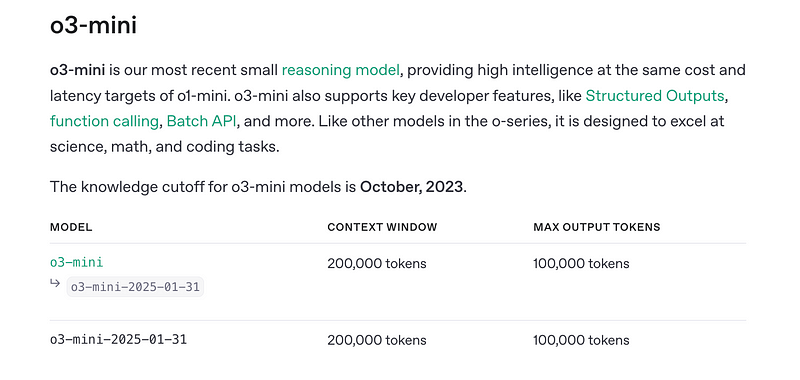

Ответом OpenAI стала o3-mini — чрезвычайно мощная, хотя и недорогая, большая модель рассуждений. Как o1 и R1, o3-mini требуется время, чтобы «подумать», прежде чем сгенерировать окончательный ответ. Этот процесс «обдумывания» значительно повышает точность конечного результата ценой более высокой задержки.

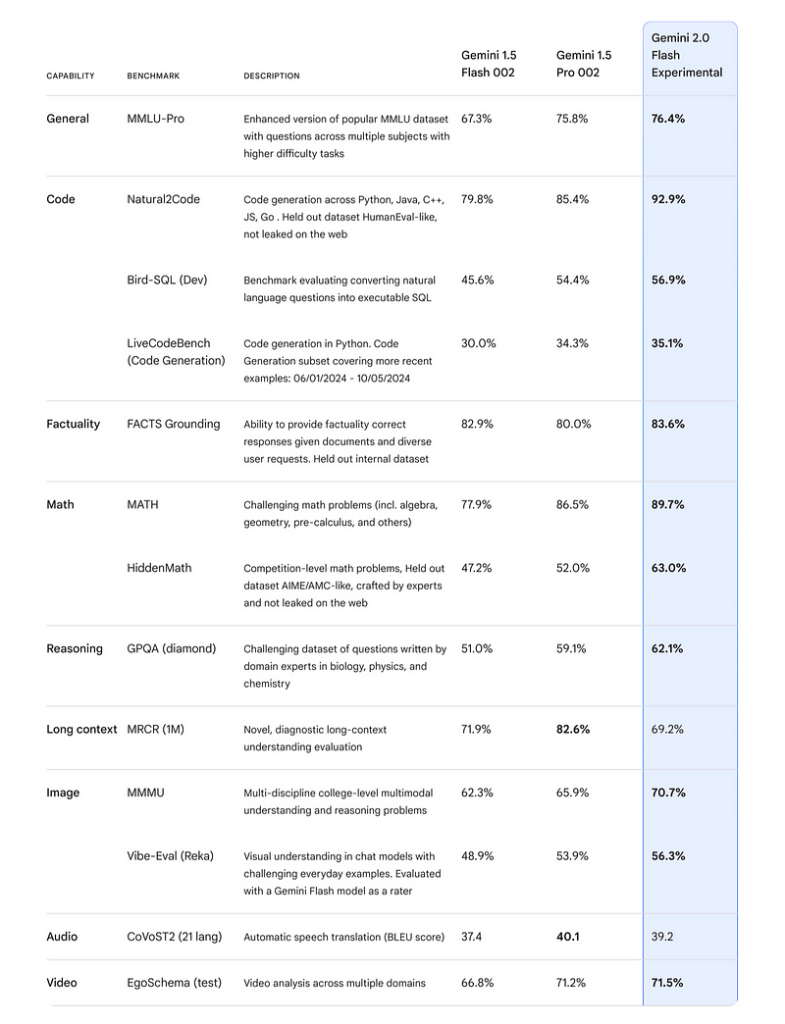

А вот Google отреагировала совершенно иначе. Она создала более совершенную модель, превосходящую по всем статьям самые мощные модели рассуждений OpenAI и DeepSeek.

Я потрясен до глубины души.

Скрытые проблемы DeepSeek R1

Когда вышла модель DeepSeek R1, я был слишком взволнован, чтобы заметить ее недостатки.

Но по мере того, как мои розовые очки стали проясняться, я обнаружил у китайской модели довольно много недоработок.

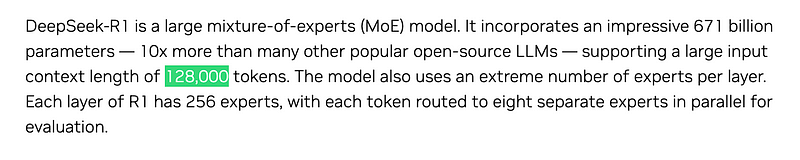

Одна из них заключается в том, что DeepSeek R1 имеет крайне малоразмерное — для современной большой языковой модели — контекстное окно.

Размер в 128 000 токенов, возможно, был бы удовлетворителен во времена GPT-3, но для реальных случаев использования этого просто недостаточно.

На самом деле мне пришлось выполнить трансформации, чтобы уменьшить контекстное окно промптов и выполнить некоторые из моих самых сложных промптов, например промпт, связанный с финансовым анализом. Это значительно снижало производительность.

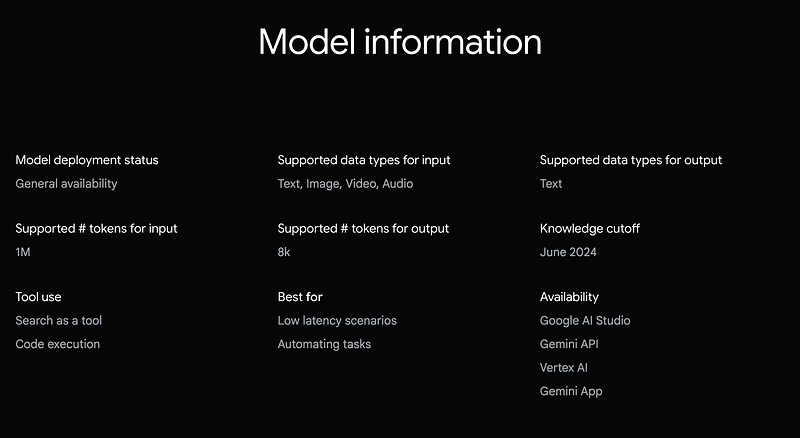

Для сравнения, модель Gemini Flash 2.0 от Google, которая намного дешевле R1, имеет контекстное окно в 1 миллион входных токенов!

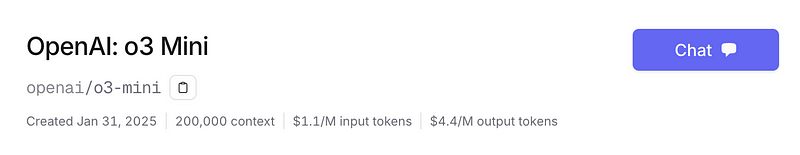

Модель o3-mini, которая немного дороже DeepSeek R1, имеет контекстное окно в 200 000 входных токенов.

Впрочем, это мелочь, учитывая, что мое приложение было создано в эпоху малоразмерных контекстных окон. Я реализовал цепочку промптов, чтобы разбить на подзадачи большинство своих объемных и сложных промптов.

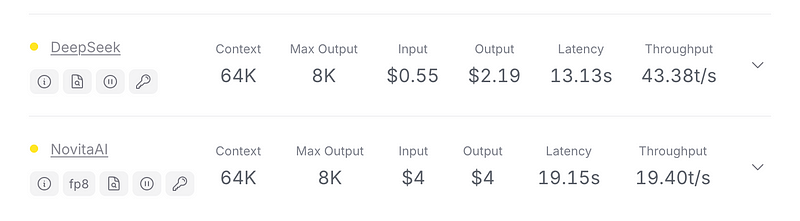

Главная, непростительная проблема DeepSeek R1 — ужасно медленная работа.

Использование любого из двух недорогих провайдеров просто неприемлемо. На выполнение комбинации промптов уходит несколько минут, что недопустимо.

В отличие от DeepSeek R1, задержка Google Gemini занимает считанные секунды, к тому же эта модель удивительно точна для своей цены.

Хотя я уже определил, что o3-mini лучше, чем DeepSeek R1, мне стало интересно, как выглядит на их фоне Gemini Flash — гораздо более дешевая модель?

Flash 2.0, DeepSeek R1 и GPT o3-mini: параллельное сравнение по генерации SQL-запросов

Чтобы сравнить эти модели, я решил предложить им выполнить серию полурандомных запросов по финансовому анализу. Моя цель — сравнить возможности Flash 2.0 с DeepSeek R1 и GPT o3-mini в сложных задачах рассуждения.

В частности, мне хотелось проверить их способность генерировать SQL-запросы. Этот тест очень важен, поскольку достаточно сложен, требует от модели тщательного следования системным промптам с учетом ограничений, а конечная точность очень важна для конечного пользователя.

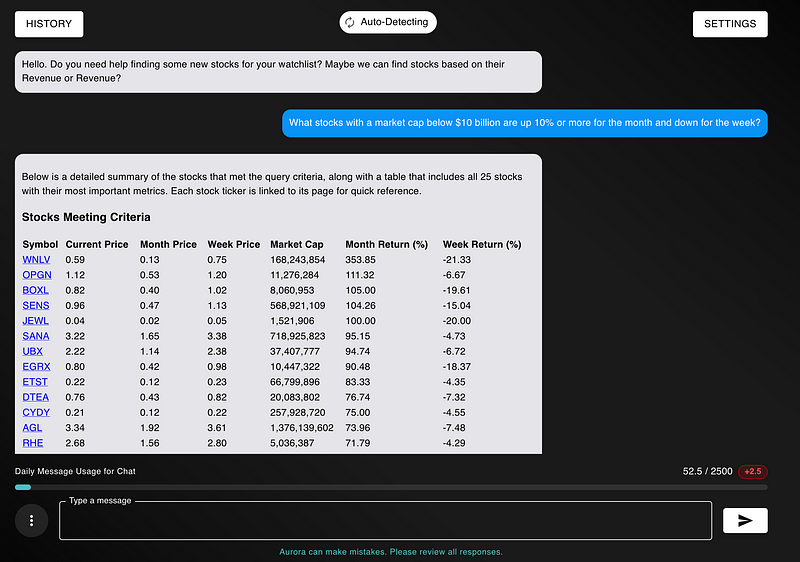

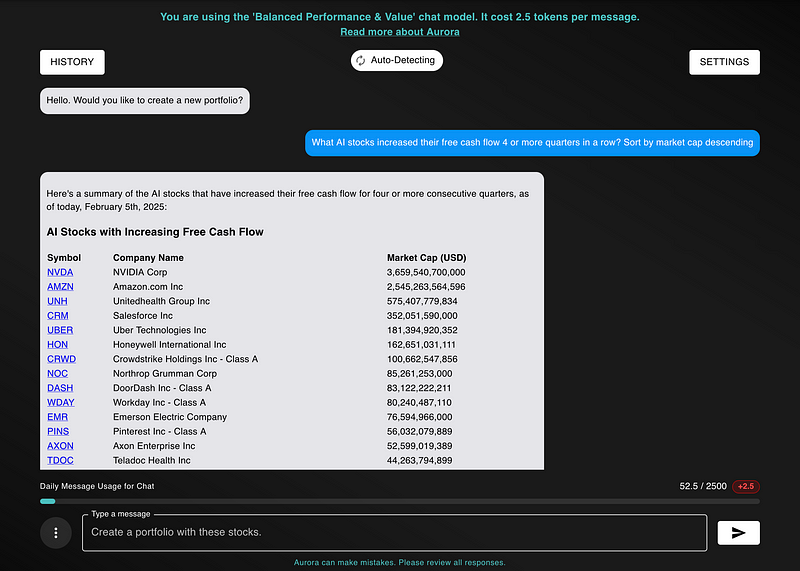

Типы запросов, собранные для тестирования, были связаны с финансовым анализом. Это объясняется тем, что моя торговая платформа, NexusTrade, имеет интерфейс на естественном языке, позволяющий инвесторам запрашивать акции с помощью ИИ.

Таким образом, выяснение того, какая модель лучше, имеет первостепенное значение. Чтобы проверить это, я протестировал три модели по следующим параметрам:

- Точность.

- Затраты.

- Относительная скорость.

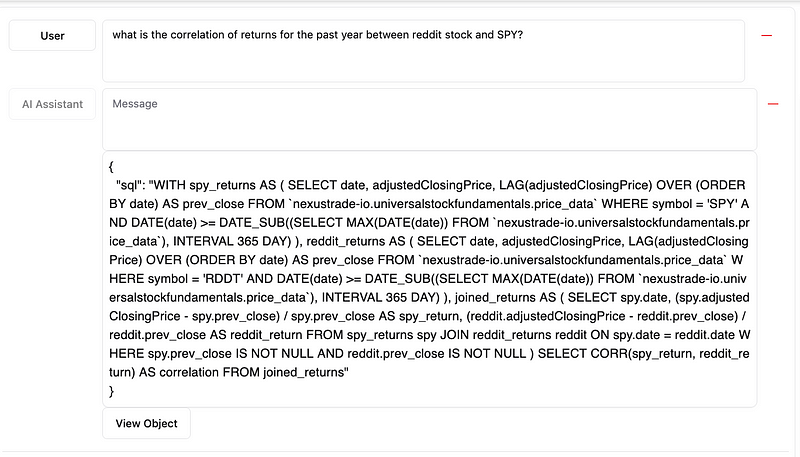

Тест на точность №1: запрос о корреляции доходности акций

В первом тесте я задал 3 моделям следующий вопрос:

Какова корреляция доходности акций Reddit и SPY за последний год?

Вот ответы.

Ответ Gemini Flash 2.0

К моему удивлению, Google Gemini ответила буквально за пару секунд.

При выполнении запроса я получил от модели следующий результат:

Это 100 % точность. Gemini получает оценку 1/1.

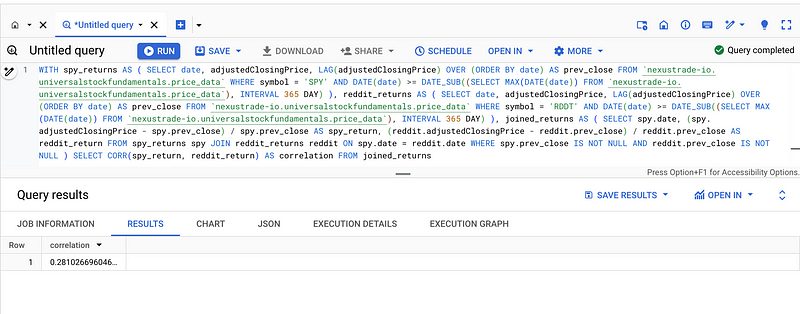

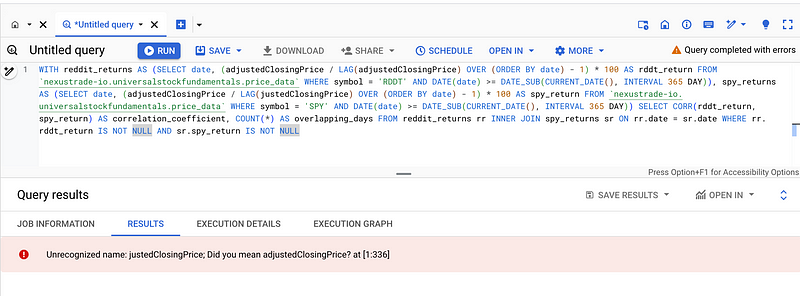

Ответ DeepSeek R1

В отличие от Google Gemini, модель DeepSeek R1 работала крайне медленно. На создание ответа у нее ушло более 30 секунд, в основном из-за компонента «рассуждения».

Затем она допустила глупую ошибку при генерации ответа.

Модель неправильно написала «adjustedClosingPrice» как «justedClosingPrice». Когда я вручную исправил эту опечатку, получил тот же ответ, что и от Google Gemini, хотя и с еще большим объемом информации, чем требовалось в запросе.

Это точный ответ, но мне пришлось вручную перепроверить логику. Таким образом, я ставлю оценку 0,7/1.

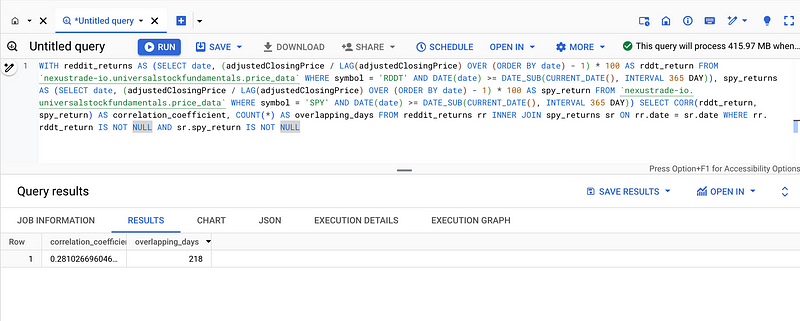

Ответ OpenAI o3-mini

Наконец, проверим ответ o3-mini. Эта модель оказалась намного быстрее, чем R1, но все же немного медленнее из-за компонента «рассуждения». Через несколько секунд она выдала следующий ответ.

Так же, как и R1, o3-mini получает вычет при оценивании, поскольку мне пришлось исправить запрос. Итоговая оценка: 0,7/1.

Таким образом, в этом тесте модель Google Gemini показала себя немного лучше, чем обе ее конкурентки! Однако это был всего лишь один тест. Посмотрим, как модели справляются с генерацией SQL-запросов другого типа.

Тест на точность № 2: запрос о росте доходов

В этом тесте был задан следующий вопрос:

Какие акции биотехнологических компаний увеличивали свою прибыль каждый квартал в течение последних 4 кварталов?

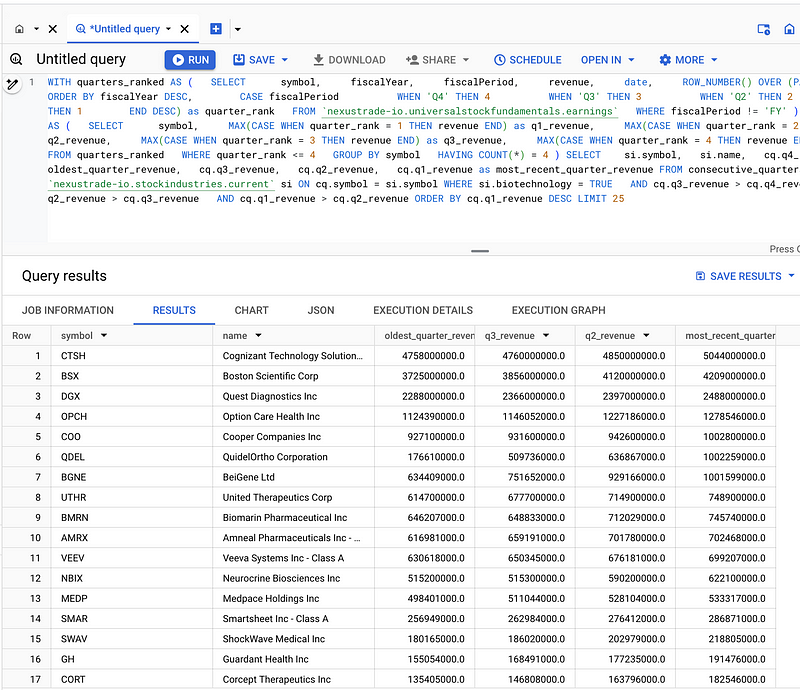

Ответ Gemini Flash 2.0

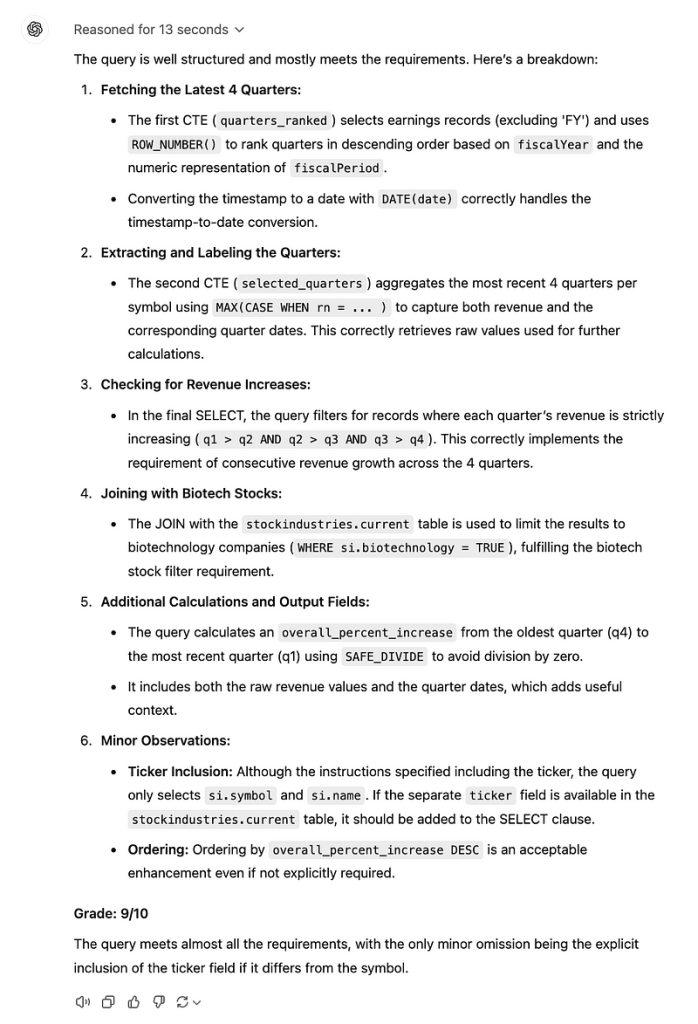

И снова Google Flash ответила через несколько секунд. При ручном осмотре запроса он выглядит правильным. Однако, чтобы перепроверить его, я попросил GPT-o3-mini-high оценить окончательный ответ. Продвинутый инструмент ИИ подтвердил мои предположения.

У модели были недостатки, но в целом она отлично справилась с задачей. Еще одна оценка 1/1 для Google!

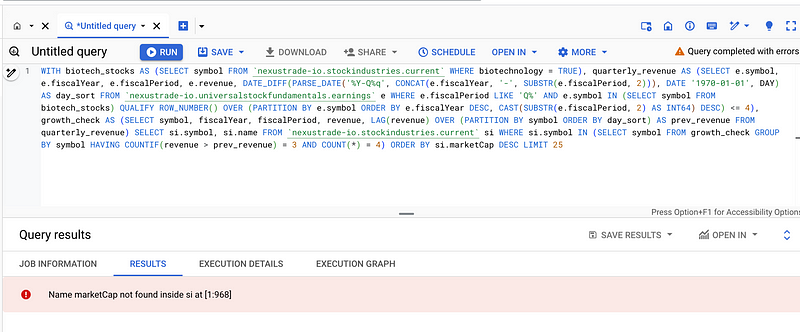

Ответ DeepSeek R1

В отличие от Google Flash, модель DeepSeek R1 плохо справилась с задачей. Запрос даже отдаленно не выглядел корректным, а когда я попытался его выполнить, он потерпел неудачу.

Не говоря уже о том, что модель потратила вечность на то, чтобы ответить… снова.

В общем, ужасная работа в этом раунде. 0/1.

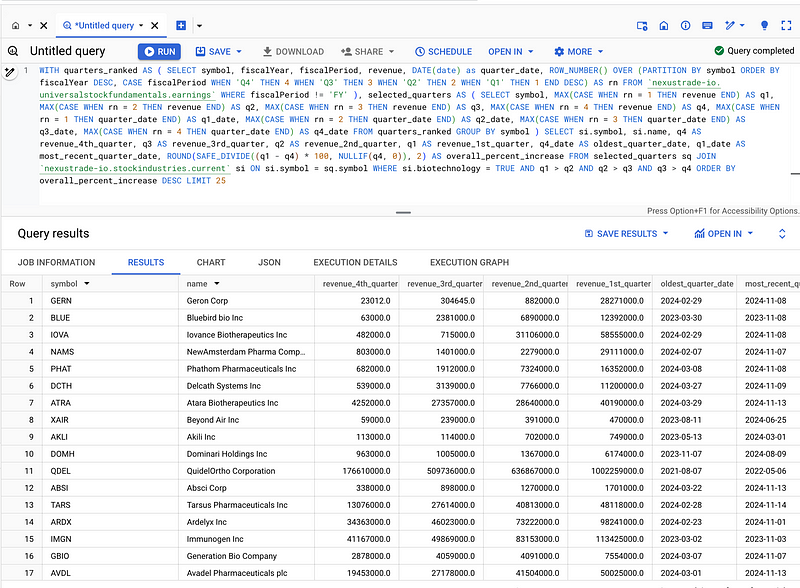

Ответ o3-mini от OpenAI

Как и в предыдущем тесте, o3-mini потребовалось на ответ умеренное количество времени, но намного меньше, чем R1. Вот окончательный ответ:

Запрос был несколько иным и извлекал другой список акций. Однако он все равно выглядел в основном точным. Я оценил его тем же способом.

Опять же, у модели o3-mini были недочеты, но ее ответ все же был технически точным. В этом раунде OpenAI получает отличную оценку!

Анализ затрат: какая модель дешевле?

Точность — не единственное, что имеет значение при сравнении LLM (больших языковых моделей). Не менее важно обратить внимание на их стоимость. Сравним все три модели с этой точки зрения.

Самой дешевой моделью на сегодняшний день является Gemini Flash 2.0. Она стоит $0,10 за миллион входных токенов и $0,40 за миллион выходных токенов.

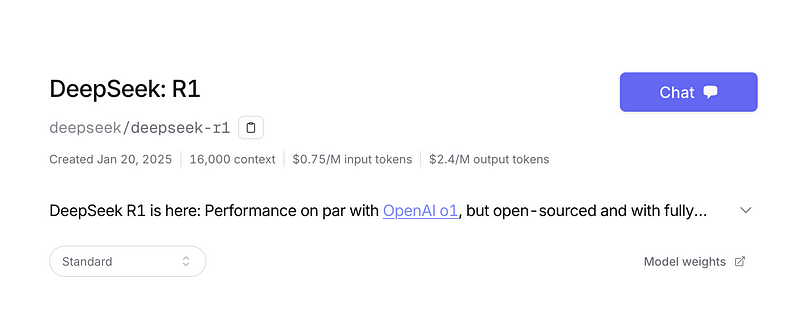

Для сравнения, стоимость R1 намного выше — примерно в 7 раз. Она стоит $0,75 за миллион входных токенов и $2,4 за миллион выходных токенов.

Наконец, модель OpenAI o3-mini — самая дорогая из всех. Она стоит $1,1 за миллион входных токенов и $4,4 за миллион выходных токенов, что делает ее в 11 раз дороже Gemini Flash и в 1,5 раза дороже R1.

Другие соображения

Как я уже упоминал, Google Gemini намного быстрее, чем две другие модели. Gemini, традиционная большая языковая модель, не тратит время на «обдумывание» вопроса перед тем, как выдать ответ. Хотя этот процесс обычно приводит к значительному увеличению точности, модели Gemini он, по-видимому, не требуется.

И наконец, Gemini имеет гораздо более существенное контекстное окно, чем две другие модели. Подведем итоги:

- Google Gemini 2.0 Flash: работала молниеносно и выполнила оба предложенных SQL-запроса на 100 % правильно с первой попытки.

- DeepSeek R1: была невыносимо медленной и выдала неправильные ответы по обоим SQL-запросам: в первом была небольшая опечатка, а второй был полностью неверным.

- OpenAI o3-mini: работала медленнее, но не критично. Немного ошиблась в первом запросе, потому что не знала тикер Reddit, и на 100 % правильно выполнила второй запрос.

Из этих тестов видно, что Google Gemini Flash 2.0 — самая мощная бюджетная модель на сегодняшний день, превосходящая более дорогие модели рассуждения. Это уверенная победа Google над конкурентами.

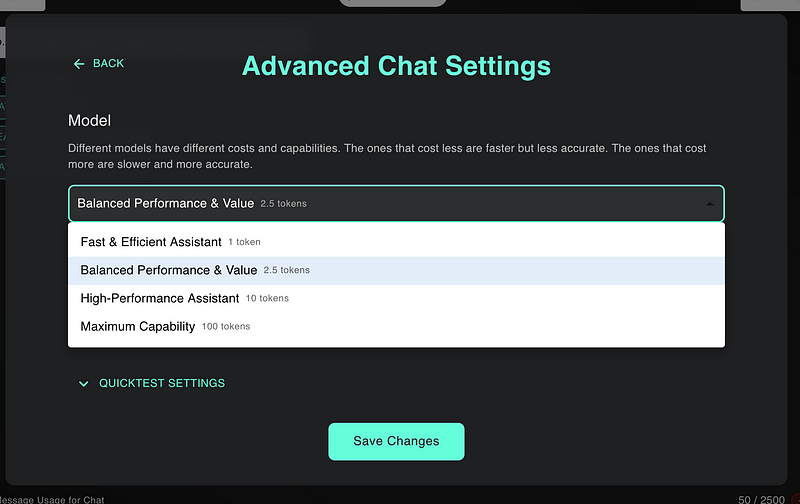

Настолько, что я тут же переделал свою торговую платформу NexusTrade, полностью удалив DeepSeek R1 и интегрировав Gemini в чат ИИ.

Теперь каждый может испытать силу высокоточного, недорогого и простого в исполнении анализа.

Спасибо Google!

Заключительные мысли

Впервые увидев стоимость Google Gemini, я планировал поставить эту модель в один ряд с дистиллированными, более слабыми моделями R1. Просто не верилось, что такой недорогой инструмент может быть настолько мощным.

Я ошибался. Google Gemini оказалась не только необычайно мощной, но и чрезвычайно недорогой моделью. По результатам моего (ограниченного, сдержанного) тестирования она буквально во всем превосходит лучшие современные модели.

Преимущества Google Gemini, выявленные в ходе этого анализа:

- Стоит меньше, чем o3-mini от OpenAI (в 10 раз) и R1 от DeepSeek (в 7 раз).

- Намного быстрее обеих моделей-конкурентов.

- Имеет гораздо более широкое контекстное окно.

- Обладает чрезвычайными способностями, возможно, даже превосходит o3-mini в подмножестве сложных SQL-задач.

Модель Google Gemini — неоспоримое доказательство того, что мы переходим к более дешевым и способным LLM. Она решительно превзошла своих конкурентов, доказав, что эра дорогих, ресурсоемких моделей закончилась. Этот прорыв знаменует собой трансформационный сдвиг в отрасли, прокладывая путь к более доступным и высокопроизводительным решениям ИИ в реальных приложениях.

Читайте также:

- ExLlamaV2: самая быстрая библиотека для работы с LLM

- 7 фреймворков для работы с LLM

- Слияние больших языковых моделей с помощью mergekit

Читайте нас в Telegram, VK и Дзен

Перевод статьи Austin Starks: Google just ANNIHILATED DeepSeek and OpenAI with their new Flash 2.0 model