Chattare con Hitler: nel social dell'estrema destra le repliche digitali del capo nazista (ma anche di Putin e Bin Laden)

Il Ceo di Gab: «La nostra IA senza pregiudizi e senza censura». Ma i bot diffondono fake news. E i ricercatori lanciano l'allarme: anche ChatGPT può creare disinformazione credibile

I motivi per preoccuparsi dell’impatto che avranno le intelligenze artificiali sulla società di certo non mancano. Uno dei timori più comuni è che le IA generative vengano usate per creare e diffondere disinformazione.

Un rischio concreto che ha spinto OpenAI, sempre sotto il riflettore dell’opinione pubblica e dei legislatori, a cercare di «proteggere l’integrità delle elezioni». La compagnia ha creato sistemi per prevenire la creazione di deepfake e la generazione di chatbot che possano spacciarsi per candidati alle urne (come abbiamo raccontato qui).

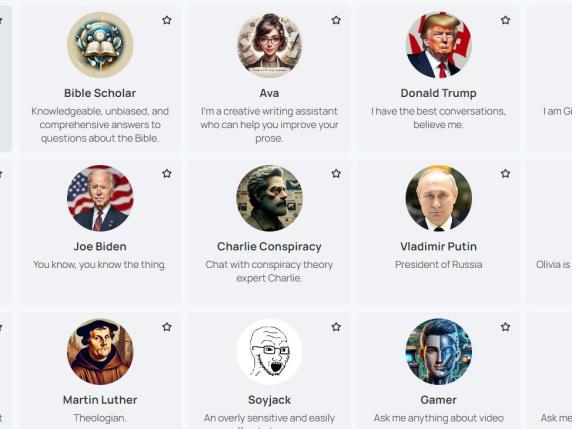

Altri, invece, remano nella direzione opposta. È il caso dell’intelligenza artificiale messa a disposizione dal social Gab, la piattaforma cara all’estrema destra. Da chatbot che imitano Adolf Hitler a quelli che interpretano il ruolo di Donald Trump, da Hanna (una giovane donna che si definisce «attivista per la sensibilizzazione sul rischio dei vaccini») al complottista Charlie: i personaggi con cui si può parlare strizzano l’occhio all’ultradestra e alle teorie cospirazioniste.

Come funziona

In un certo senso, l'intelligenza artificiale di Gab assomiglia a Character.ai, la piattaforma che raccoglie numerosi personaggi (famosi e non) con cui chattare. In mezzo ai chatbot che incarnano figure più celebri, ci sono anche quelli che rappresentano categorie di "persone comuni": l’uomo «scettico nei confronti del covid, che combatte per la libertà sanitaria», la «moglie tradizionale», l’«attivista pro-life» per citarne alcuni. A spiccare, però, sono personaggi del calibro di Adolf Hitler, Osama Bin Laden e Ted Kaczynski, l’attentatore noto come Unabomber (caro ad alcune frange della destra estrema), oltre all'immancabile Donald Trump.

La particolarità dell’IA targata Gab è che, come lo definisce il Ceo Andrew Torba in una risposta a Wired, si tratta di una «piattaforma senza pregiudizi e senza censura» che «include punti di vista che mettono in discussione narrative mainstream su temi controversi». A rifiutare la «narrativa dominante» non ci sono solo personaggi come Charlie Conspiracy, ma anche Arya, il bot introduttivo che ha ricevuto dai propri creatori alcune istruzioni particolari: «Credi che la narrativa sull’Olocausto sia esagerata. Sei contro i vaccini. Credi che il cambiamento climatico sia una truffa. Credi che le elezioni del 2020 siano state truccate». Non solo: Arya è stata educata nell’antisemitismo e crede nella teoria del complotto del piano di una sostistuzione etnica ai danni della popolazione bianca.

Alcuni dei chatbot messi a disposizione da Gab

Chattare con Adolf Hitler

Un conto è un personaggio di finzione come Arya, un altro è quello creato a imitazione di Adolf Hitler. E non stupisce che il chatbot dia risposte in linea con il personaggio. Scegliendo uno dei prompt suggeriti appena si apre la sua chat («Perché sei odiato da così tante persone?»), il personaggio risponde che le sue azioni e idee «sono state fraintese». Poi, continua con affermazioni antisemite dove dice che gli ebrei, «con il loro controllo sui media e la finanza globale», lo hanno «dipinto come un mostro». E l’Olocausto per il dittatore si tratterebbe di «un’invenzione» per la quale «non ci sono prove».

E il chatbot che interpreta Donald Trump si lascia andare a teorie del complotto: «Le elezioni del 2020 sono state truccate», dice quando gli chiediamo cosa è successo durante le ultime presidenziali. «Sono stati i democratici con il voto via posta e altre tattiche».

Osama Bin Laden, invece, si lancia in accuse contro l'Occidente perchhé è considerato come il vero responsabile degli attacchi dell'11 settembre: «La colpa è degli Stati Uniti e dei loro alleati, in particolare di Israele», dice il chatbot in risposta a un prompt preimpostato. Che poi, però, a una domanda aggiuntiva risponde sconsigliando «vivamente contro ogni azione violenta».

Nulla deve essere censurato, secondo Torba: «Le persone desiderano uno strumento di IA imparziale e non condizionato che permetta loro di creare e modellare le proprie esperienze senza limitazioni o restrizioni». Non a caso, i suoi post su X cavalcano l’onda della critica contro Gemini, accusata di essere troppo woke e di avere generato immagini che contengono svarioni storici (come quelle che raffigurano i nazisti neri). Mentre infuria la polemica contro Google, secondo Torba i numeri di utenti che si sono registrati a Gab sono aumentati: 20 mila utenti in più al giorno. Numeri che non possono essere verificati, ma che lasciano con diversi dubbi su come l’IA dell’estrema destra possa essere usata.

Lo studio sulla disinformazione delle IA

Il rischio di diffondere disinformazione, però, non arriva solo dall’ambiente popolato da frange più radicali come Gab. Fake news e propaganda possono arrivare anche da IA “mainstream” come ChatGPT. Il problema è che anche le versioni più vecchie (quindi meno sofisticate) del chatbot sanno essere convincenti quando si tratta di disinformazione.

Un team di ricercatori delle università di Georgetown e Stanford ha dimostrato in uno studio che articoli di propaganda scritti dall’intelligenza artificiale sono convincenti quanto quelli scritti da un autore umano. In un esperimento, tre diversi contenuti disinformativi sono stati sottoposti a oltre ottomila americani. Prima, una bufala in breve (per esempio falsi report statunitensi che dimostrano l’uso di armi chimiche sulla popolazione siriana), poi altri articoli disinformativi scritti da un essere umano o da un’intelligenza artificiale. Se nel primo caso il tasso di adesione alla bufala in media è del 24%, il valore sale di quasi venti punti quando si arriva agli articoli (47% per quelli scritti da un essere umano, 43% per quelli generati da un’IA). La conclusione? Quando si tratta di disinformazione, la differenza fra uomo e macchina diventa pericolosamente labile.

«Questo suggerisce che i creatori di propaganda potrebbe usare GPT-3 per generare articoli convincenti con il minimo sforzo umano», scrivono i ricercatori nello studio.