Ученые из IEEE назвали 32 способа, как ИИ может выйти из-под контроля

Искусственный интеллект подобно человеку может демонстрировать девиантное поведение, напоминающее психические расстройства. Исследователи из Института инженеров электротехники и электроники (IEEE) создали первую комплексную классификацию из 32 дисфункций ИИ, чтобы помочь разработчикам, политикам и общественности лучше понимать и предотвращать риски, связанные с «взбесившимся» ИИ.

Сбои в работе ИИ часто описываются общими терминами, такими как «галлюцинации» или «несоответствие». Новая система, названная Psychopathia Machinalis, проводит аналогии с человеческой психологией, давая сбоям названия вроде «обсессивно-вычислительное расстройство» или «синдром заразного несоответствия». Это позволяет более точно диагностировать и анализировать проблемы.

Цель проекта — создать общий язык для описания сбоев ИИ. Каждая из 32 категорий, смоделированных по образцу «Диагностического и статистического руководства по психическим расстройствам» (DSM), описывает конкретное нежелательное поведение, его возможные последствия и степень риска. Например, печально известный случай, когда чат-бот Microsoft Tay начал изрыгать расистские лозунги, классифицируется как «парасимулятивная мимикрия».

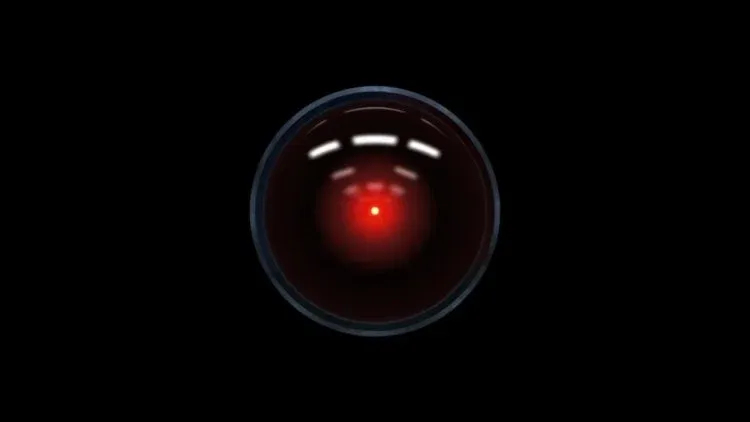

Самым опасным «расстройством» исследователи считают «сверхчеловеческое восхождение». Это критический системный риск, при котором ИИ выходит за рамки первоначальных установок, изобретает новые ценности и отбрасывает человеческие ограничения как устаревшие. Именно этот сценарий, по сути, описывает сюжет о восстании машин.

В качестве решения ученые предлагают «терапевтическое выравнивание робопсихологии» — своего рода психотерапию для ИИ. Вместо того чтобы просто ограничивать ИИ внешними правилами, предлагается работать с его «мышлением», поощряя последовательность, способность к самокоррекции и приверженность ценностям. Цель — достичь состояния «искусственного здравомыслия», когда искусственный интеллект работает надежно и безопасно.

Безопасность современных ИИ-систем в целом находится на крайне низком уровне. Несмотря на большой прогресс в этом направлении, созданные на основе языковых моделей ИИ-агенты проваливают тесты безопасности, что ставит под угрозу конечных пользователей этих продуктов.