Александр Куманев

Дипфейки становятся повседневностью

Новые технологии не только открывают возможности, но и приводят к проблемам. Еще год назад мошенники создавали дипфейки публичных персон и чиновников, чтобы обманывать целые группы граждан. Сейчас же аферисты все чаще переходят на целенаправленные атаки и незначительные суммы.

Жертвой мошенников стал корреспондент РИА «Новости». В мессенджере Telegram она получила «кружок» якобы от подруги, празднующей день рождения. Именинница попросила перевести фотографу 20 тыс. рублей, поскольку у нее не проходила операция. Корреспондент согласилась, а совершить перевод удалось только с третьей попытки — первые два банка отклоняли транзакцию как подозрительную. Как только перевод прошел, аккаунт «именинницы» был удален.

Таким образом, мошенники взломали аккаунт подруги, создали убедительный дипфейк, который не удалось определить при просмотре, знали о празднике и нашли подход к жертве, используя методы социальной инженерии. Все это не ради миллионов, а за 20 тыс. рублей. Судя по удалению аккаунта сразу после перевода, у злоумышленников не было других целей.

«В банке жертве сказали, что вернуть деньги не получится», — отметили в РИА «Новости».

Одна из жертв мошенников, попавшая в аналогичную ситуацию, рассказала, как ее обманули.

Схема не нова, а потерявших деньги все больше

Еще месяц назад член комитета Госдумы по информполитике Антон Немкин предупреждал о появлении подобной схемы.

«Все больше распространяется практика взлома личных аккаунтов граждан в мессенджерах и отправки голосовых сообщений либо „кружочков“ контактам. Благодаря ИИ злоумышленники могут подделывать голос и мимику, создавая реалистичные видео с якобы знакомыми людьми», — предупредил он (цитата по РИА «Новости»).

Руководитель направления исследования данных в «Лаборатории Касперского» Дмитрий Аникин уточнил, что мошенники нередко используют голосовые и видеоподделки для обмана граждан. В ход идут методы социальной инженерии, поскольку после взлома аккаунтов аферисты получают доступ к переписке с потенциальной жертвой и даже могут продолжить разговор.

Конечной целью может стать эмоциональный призыв с просьбой о помощи (переводе денег) или приглашение воспользоваться выгодным предложением. Напомним, что целью злоумышленников может быть и конфиденциальная информация.

«Фактически можно говорить о том, что дипфейки становятся дополнительным инструментом в социальном инжиниринге при попытках финансовых краж. В будущем качество таких подделок будет совершенствоваться, технологии для их создания станут еще более доступными, поэтому проявлять осторожность при получении аудио- и видеоконтента в социальных сетях и мессенджерах необходимо уже сейчас», — объяснил Аникин.

Эксперты MTS AI считают, что до конца года каждый второй россиянин столкнется с дипфейк-атакой.

«Рост количества дипфейк-атак — тревожный, но вполне прогнозируемый тренд. Сегодня технологии синтеза речи и видео настолько продвинулись, что подделать голос и даже образ человека стало делом буквально нескольких минут», — сообщал Немкин в мае.

Реальнее реальности: большинство россиян уже не могут определить дипфейк

Злоумышленники активно используют дипфейки в самых разных сферах. Они распространяют поддельные видео и аудио от имени глав регионов или районов во время обстрелов, диверсий и атак беспилотников, чтобы посеять панику у населения или выманить деньги. Выдают себя за знаменитостей и родственников, пытаясь выудить деньги. Обращаются к сотрудникам от имени начальства. Создают фейковые аккаунты со сгенерированными фото и видео, в том числе на сайтах знакомств.

Визуально определить дипфейк становится все сложнее — уже сейчас более половины россиян не могут этого сделать.

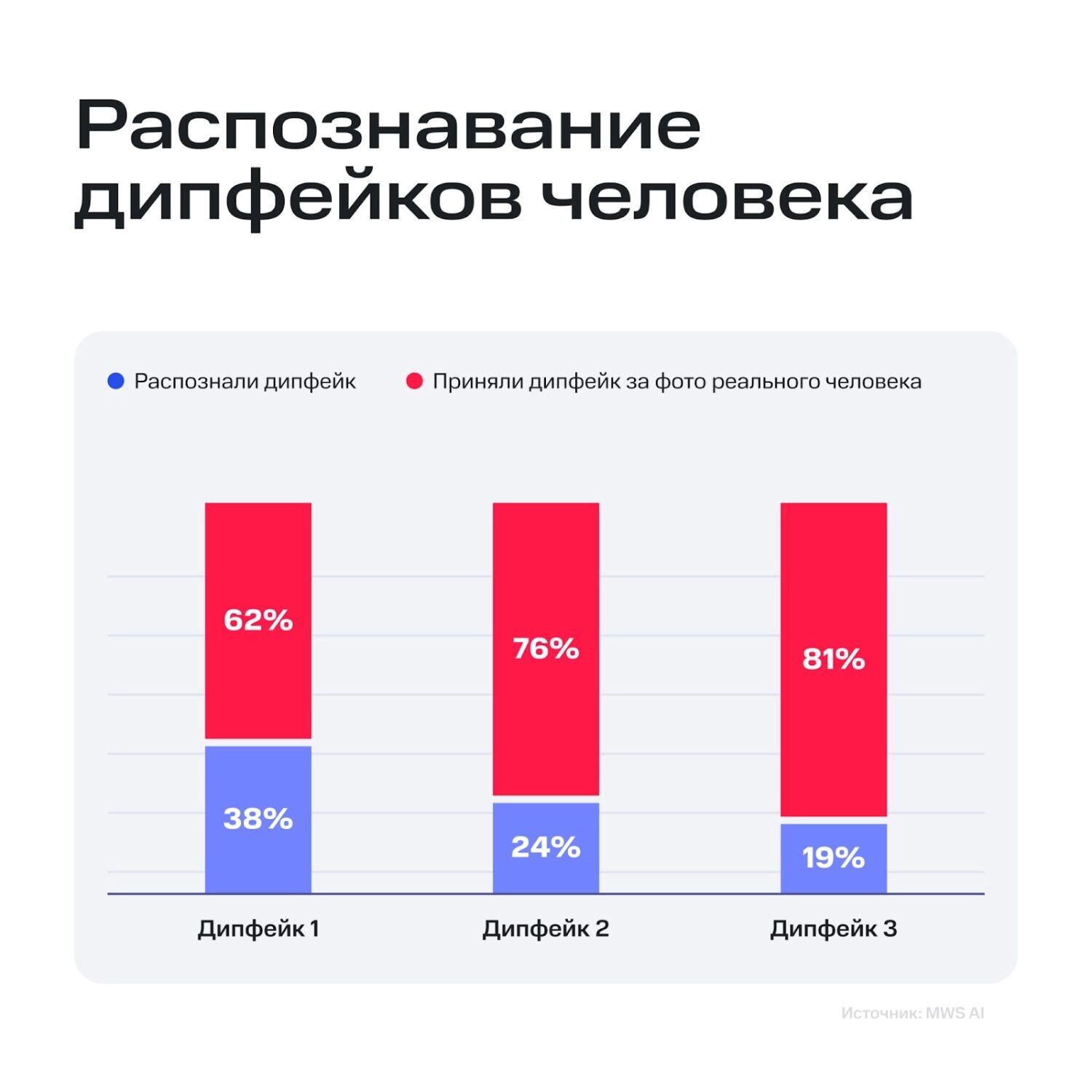

Компания MTS AI провела исследование, в котором участвовали 1600 граждан. Им показали десять изображений людей, четверо из которых были сгенерированы ИИ: три — с помощью специализированной нейросети, одно — с помощью обычной большой языковой модели на основе текстового описания.

76% респондентов определили дипфейк, созданный обычной моделью, но с остальными тремя изображениями ситуация противоположная — от 62% до 81% посчитали их настоящими. Исследователи подчеркнули, что детектор дипфейков Visionlabs корректно обнаружил все сгенерированные картинки.

Не только видеозаписи, но и прямые трансляции: делать дипфейки становится все проще

Это же касается и видео. Еще год назад неосторожное движение и артефакты в кадре могли выдать дипфейк, а сейчас существуют инструменты, способные работать в прямых трансляциях. Один из энтузиастов показал, как выглядит подмена лица в реальном времени.

«Если это общедоступная (программа. — Прим. ред.), то представьте, что есть у правительства», — отмечает автор видео.

«Эти вызовы связаны с поразительной простотой создания дипфейков — крайне реалистичных и одновременно с этим не отражающих реальности изображений, видеороликов, записей голоса с участием кого угодно — политиков, известных актеров, родственников, знакомых и друзей», — отметил он.

Заместитель директора по продуктам VisionLabs Татьяна Дешкина в беседе с РИА «Новости» объяснила, что киберпреступникам достаточно записать 20 секунд голоса с разной интонацией, чтобы клонировать его, а чем дольше запись, тем качественнее будет подделка. Далее они накладывают различные эффекты и шумы, чтобы создать реалистичный фон. Именно для записи голоса мошенники обзванивают россиян с просьбой поучаствовать в опросах.

«Подтверждаю лично: вчера в течение дня супруга заблокировала 5 (пять) номеров телефонов, с которых звонили с целью якобы соцопроса», — рассказал экс-депутат Госдумы Вячеслав Лысаков.

«Как раз сегодня звонил „исследовательский центр“. Креативят неустанно. Иной раз закрадывается сомнение: а (украинцы. — Прим. ред.) ли это?» — поделился своим опытом политолог Георгий Бовт.

Как в России борются с дипфейками и борются ли?

Мошенники используют дипфейки, чтобы проходить онлайн-идентификацию, выдавая себя за других людей. В прошлом им удавалось обманывать и сотрудников банков, но сейчас коммерческие структуры все чаще используют средства защиты. Дипфейки применялись и для прохождения собеседований.

РБК отмечает, что сервисы видеосвязи начали внедрять детекторы дипфейков. «Коммерсант» уточняет, что подобные инструменты работают уже в трех десятках проектов, половина из которых — банки. Руководитель компании «Интернет-розыск» Игорь Бедеров объяснил, что детекторы «видят» больше человеческого глаза, пытаясь обнаружить элементы машинной логики.

В «Сбере» призвали сделать распознавание дипфейков обязательным стандартом и внедрить технологию в массовые сервисы. Директор по продуктам VisionLabs Татьяна Дешкина считает, что финансовые организации и государственные сервисы могут защитить пользователей с помощью многофакторной аутентификации и дипфейк-детекторов. По ее мнению, встроенные системы распознавания сгенерированного контента в ближайшем будущем появятся в смартфонах, соцсетях и мессенджерах.

Соучредитель Сообщества профессионалов в области приватности Алексей Мунтян же не считает, что сейчас проблема не носит критического социального характера. По его мнению, для создания качественной подделки в режиме реального времени нужны существенные ресурсы и технологии. При этом он признает, что в будущем ситуация может измениться.

«Учитывая развитие технологий и недорогих решений в этой сфере, вполне возможно, что банки, образно говоря, готовят сани летом, рассматривая ближайшую перспективу, когда это явление станет массовым», — предположил Мунтян.

Обработка видео действительно требует много ресурсов, если говорить о пользовательских ПК, но сервисы ИИ чаще используют собственные серверы, да и мошенники могут использовать серьезное оборудование. Необходимость в установке ПО есть далеко не всегда, некоторые программы могут работать в браузере. Для создания маски достаточно всего одной фотографии, хотя это едва ли поможет создать действительно убедительную подделку.

Стоит отметить, что нейросети уже способны создавать достаточно правдоподобные дипфейки в режиме реального времени, что можно понять по ролику китайского блогера, опубликованному год назад.

Как сообщают «Ведомости», Минцифры разрабатывает законопроект, предусматривающий уголовную ответственность за применение ИИ при совершении противоправных действий. Их выделят в отдельный вид преступлений. Опрошенные изданием эксперты предполагают, что регулятор приравняет ИИ к «орудию преступления» и отягчающему обстоятельству.

«Законопроект вносит поправки в несколько статей УК РФ. Так, в ст. 158 („Кража“), ст. 159 („Мошенничество“), ст. 163 („Вымогательство“), ст. 272 („Злостное воздействие на информационную систему, информационно-телекоммуникационную сеть, компьютерную информацию или сеть электросвязи“) и ст. 274 („Нарушение правил эксплуатации средств хранения, обработки или передачи компьютерной информации и информационно-телекоммуникационных сетей“) УК РФ», — передают «Ведомости».

Таким образом, под действие закона будут подпадать не только дипфейки, но и любые другие системы обработки данных, которые способны выдавать результаты, сопоставимые с человеческим интеллектом. Максимальное наказание выглядит достаточно суровым — до 15 лет лишения свободы и штраф до 2 млн рублей (в зависимости от статьи).

«Интересный момент: ответственность исключается, если ИИ использовался против заблокированных в России ресурсов. Получается легализация кибератак на „недружественные“ платформы?» — обратили внимание в SecurityLab.

Уголовная ответственность за использование дипфейков при совершении преступлений уже применяется в некоторых странах. Сенатор Клишас отметил, что в США есть так называемый закон «Уберите это». По заявлению лица интернет-платформа должна удалить дипфейки, а за их публикацию грозит тюрьма. Клишас добавил, что этот закон имеет весьма ограниченные возможности противодействия дипфейкам, а также может применяться для удаления «неудобного», но подлинного контента.

По его мнению, поиск решений идет во многих странах мира, а примеры зарубежной законодательной практики нужно изучать и в России.

Зарубежный опыт: дипфейки и ИИ уже использует полиция

К слову, в США дипфейки используют не только злоумышленники, спецслужбы, но и полиция. Как сообщает Wired, полицейские управления заключили контракт с проектом Massive Blue «за непроверенную и секретную технологию» Overwatch. В частности, создаются реалистичные аккаунты в соцсетях и мессенджерах, которые ведет ИИ. Такие боты используются в качестве подсадных уток, помогая выявлять преступников, в том числе потенциальных.

«Они (боты. — Прим. ред.) общались с людьми, которых они подозревают в совершении любых преступлений, от насильственных сексуальных преступлений до неопределенно определенных „протестующих“, в надежде собрать доказательства, которые можно будет использовать против них», — пишет Wired.

Издание отмечает, что правоохранительные органы предприняли шаги, чтобы не допустить обнародования подробностей о том, что такое Massive Blue и как он работает. Утверждается, что на основании полученных от ботов данных не произведено ни одного ареста, но как и с какой целью они применяются, не раскрывается.

По всей видимости, целью является сбор данных, в том числе составление профиля, сбор геоданных и криптокошельков, формирование «разведотчетов». Эффективность ботов зависит от того, насколько достоверно они играют свои роли. Параллельно с этим система сканирует соцсети и мессенджеры на предмет потенциально интересных аккаунтов.

Не раскрывается и вопрос, ограничивается ли ИИ сбором доказательств или же может подталкивать подозрительных пользователей на преступления и создавать «сообщества». С учетом потенциала технологии уже вскоре она может стать серьезным оружием в руках спецслужб разных стран.

Как защитить себя и близких от дипфейков

Очевидно, что голос, фото и видео уже перестают быть неопровержимым доказательством. Злоумышленники способны выдавать себя даже за знакомых жертвы, подделывая их образ. Аникин рекомендует критически относиться к любым сообщениям, связанным с переводом денег, переходом по ссылке, скачиванием файлов.

Эксперты по кибербезопасности компании F6 F6призвали руководствоваться принципом «нулевого доверия». Они рекомендуют сохранять бдительность, особенно если обращение содержит неожиданные и шокирующие события. Если знакомый прислал сообщение с чужого аккаунта, то это повод для подозрений. Существуют сервисы для проверки фото-, аудио- и видеофайлов на предмет генерации.

Что может выдать дипфейк:

- явную границу наложения;

- ошибки наложения при движении головы, особенно при поворотах (лучше всего дипфейк получается на спокойном выражении лица с профилем в фас);

- различия в цвете, освещенности и качестве картинки;

- ошибки в мимике (отдельное внимание на моргание, движение губ);

- неправильную прорисовку глаз и конкретно зрачков;

- исчезновение родинок и шрамов;

- кратковременное проступание элементов оригинального изображения поверх наложенного;

- несовпадение формы головы, прически, комплекции и голоса актера и наложенной личности;

- мерцание, пикселизацию или замыливание видео или отдельных его элементов;

- общее плохое качество видео в попытке замаскировать несовершенство дипфейка).

На примерах можно заметить, что авторы стараются избегать волос, — это все еще слабая сторона ИИ.

При возникновении подозрений необходимо задать уточняющий вопрос, ответ на который не могут знать посторонние. Можно позвонить знакомому на телефон, чтобы уточнить информацию. Мошенники используют методы социальной инженерии, но в прямом разговоре они могут выдать себя.

Киберпреступники могут использовать ваши фото, видео и голос для создания контента. Чтобы противостоять этому и помешать обмануть родственников и знакомых, необходимо уделять внимание своей кибербезопасности: не переходить по подозрительным ссылкам, не диктовать и не пересылать коды из СМС, использовать двухфакторную аутентификацию и сложные пароли, не давать компьютер и телефон посторонним.

Для создания дипфейков мошенникам не обязательно нужно взламывать аккаунты — они могут использовать информацию в открытом доступе: фото, видео, голос. Чем больше данных им удастся собрать, тем убедительнее будет выглядеть подделка. В связи с этим нелишним будет ограничить публикацию общедоступного контента.