Nella metro di Londra c’è una intelligenza artificiale che controlla ogni passeggero. L’allarme: «Viola la privacy»

Gli esperti di privacy lanciano l'allarme: «L'uso di questa tecnologia solleva problematiche etiche e sociali». Perché in Unione europea sarebbe vietata

Dalla stazione della metro Willesden Green, nel nord-est di Londra, ogni giorno transitano oltre 25 mila passeggeri. I viaggiatori non sanno di essere stati controllati da un’intelligenza artificiale sperimentale che per un anno ha tracciato, registrato e analizzato ogni movimento, comportamento sospetto o azione sopra le righe.

Le prove generali per questa nuova tecnologia sono terminate a settembre 2023, dopo un anno dal lancio dei primi test. Per diversi esperti e associazioni si tratta di una violazione della privacy dei cittadini oltre che un tradimento della loro fiducia, visto che a lungo sono rimasti all’oscuro dell’esperimento.

Come funziona

Le informazioni sui test sono state ricavate da un documento consultato da Wired grazie al Freedom of Information Act. Nel testo si legge che i dati su cui l’intelligenza artificiale è stata allenata arrivano dalle numerose telecamere di sicurezza disseminate in tutta la stazione della metro. Quando il software individua un comportamento sospetto, una notifica viene inviata agli iPad o computer dei dipendenti che lavorano a Willesden Green.

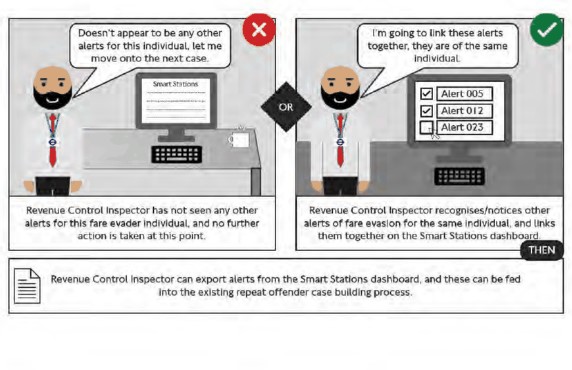

L’intelligenza artificiale usata nella metro in realtà è composta da più algoritmi, ognuno creato per rilevare uno specifico comportamento pericoloso o che richiede l’attenzione del personale: generale movimento della folla nella stazione, eventuali accessi non autorizzati, sicurezza delle persone che viaggiano, assistenza alla mobilità, rilevazione di comportamenti criminali o antisociali, presenza di una persona sui binari, segnalazione in caso di malore di un passeggero o in caso di pericoli per la sicurezza come il pavimento bagnato, oggetti lasciati incustoditi, clienti bloccati e, non per ultimo, il «salto del tornello». Una lunga lista di comportamenti che, a sua volta, è divisa in numerose altre categorie.

Riconoscere un'aggressione

Durante l’anno di sperimentazione sono stati mandati oltre 44 mila notifiche allo staff della metro. Di queste, quasi 26 mila sono state mandate per segnalare passeggeri che non pagano il biglietto. Un problema significativo per il sistema trasporti di Londra, che per questo motivo ogni anno perde l’equivalente di 150 milioni di euro.

Facile finché si tratta di rilevare il salto del tornello. Addestrare l’algoritmo a riconoscere le armi, però, si è rivelata tutta un’altra storia. Per allenare l’IA a riconoscere oggetti pericolosi la polizia partecipava di notte, mentre la stazione era chiusa, ai test. Per un addestramento più efficace, gli agenti portavano con sé armi come machete o pistole.

Ancora più difficile è stato allenare l’algoritmo a riconoscere i segnali di un’aggressione. Un compito per nulla semplice e dai risultati insoddisfacenti (gli alert inviati sono stati 66, se si contano anche le immagini usate come simulazione), tanto che la stessa azienda che gestisce il sistema di trasporti, il Transport for London, ha dovuto accettare di essere «impossibilitata a individuare con successo le aggressioni».

Problemi tecnici

La difficoltà nel rilevare azioni violente non è l’unica incontrata durante la sperimentazione. L’impossibilità di distinguere fra biciclette pieghevoli e quelle regolari (che non possono essere portate sul trasporto pubblico) rende difficile monitorare questo tipo di infrazione. Non solo: i bambini che passano dai tornelli al seguito dei genitori hanno dato spesso un «falso positivo». I piccoli passeggeri, infatti, venivano etichettati dall’IA come «evasori del biglietto». Un problema facilmente individuabile da un controllore umano, ma un problema più complesso per l’algoritmo. Alla fine ha prevalso la soluzione più semplice: ok segnalare un target, ma solo se è più alto degli stessi tornelli.

Ma i problemi tecnici, però, non sono quelli che preoccupano di più gli esperti e le associazioni che si occupano di privacy.

Dubbi sul rispetto della privacy

Non solo sono state espresse perplessità sui potenziali bias che una simile tecnologia può portarsi dietro dal suo addestramento. Soprattutto, a suscitare polemiche è il potenziale impatto che un’IA come questa può avere sulla privacy dei passeggeri che, come hanno denunciato gli esperti, non erano stati neppure informati della sperimentazione.

«Sebbene questi test non coinvolgessero software di riconoscimento facciale, l’uso dell’IA in uno spazio pubblico per identificare comportamenti, analizzare linguaggio del corpo e dedurre caratteristiche sensibili solleva molte delle stesse problematiche scientifiche, etiche, legali e sociali», ha commentato Michael Birtwistle, direttore associato dell’istituto di ricerca Ada Lovelace.

Una preoccupazione anche sul trattamento dei dati. In una prima fase dei test, infatti, i volti dei passeggeri erano stati oscurati, mentre i dati non venivano conservati a sistema per più di 14 giorni. Ma dopo diverse settimane di test e numerose notifiche sui passeggeri che non pagano il biglietto, le politiche sul trattamento dei dati sono state cambiate. Così, i volti dei trasgressori sono stati resi visibili, mentre i dati sono stati conservati per più di due settimane.

In Ue non si può fare

La sperimentazione si è conclusa lo scorso settembre, ma non è chiaro se nuovi test verranno svolti in futuro in altre stazioni o se il sistema verrà implementato così da sviluppare funzionalità di riconoscimento facciale.

Simili tecnologie, però, non potrebbero essere testate così facilmente se, dopo il referendum del 2017, il Regno Unito non avesse lasciato l’Unione europea. Grazie alla Brexit, infatti, il Paese non dovrà sottostare alle regole dell’AI act. Secondo il regolamento europeo, tecnologie come quella sperimentata nella metro di Londra potrebbero rappresentare un alto rischio per i diritti individuali e, per questo motivo, dovrebbero sottostare a una serie di requisiti stringenti.

Mentre in Ue si è quasi pronti per approvare l’AI Act, infatti, nel Regno Unito si parla ancora di come regolare le nuove tecnologie. A inizio febbraio il governo britannico ha annunciato di voler stanziare 100 milioni di sterline per la creazione di centri di ricerca sull’intelligenza artificiale. Un decimo di questi fondi saranno usati per sviluppare strumenti per monitorare i rischi delle intelligenze artificiali. Un passo avanti per il Regno Unito, ma ancora lontano da una regolamentazione indirizzata proprio ai casi come quello della stazione di Willesden Green.