«Это революция»

В последнее время искусственный интеллект активно внедряется в систему госуправления. Так, заместитель губернатора Нижегородской области Егор Поляков рассказал в своем Telegram-канале, что новые технологии будут использованы региональным минлесхозом для выявления стихийных повреждений и незаконной вырубки леса.

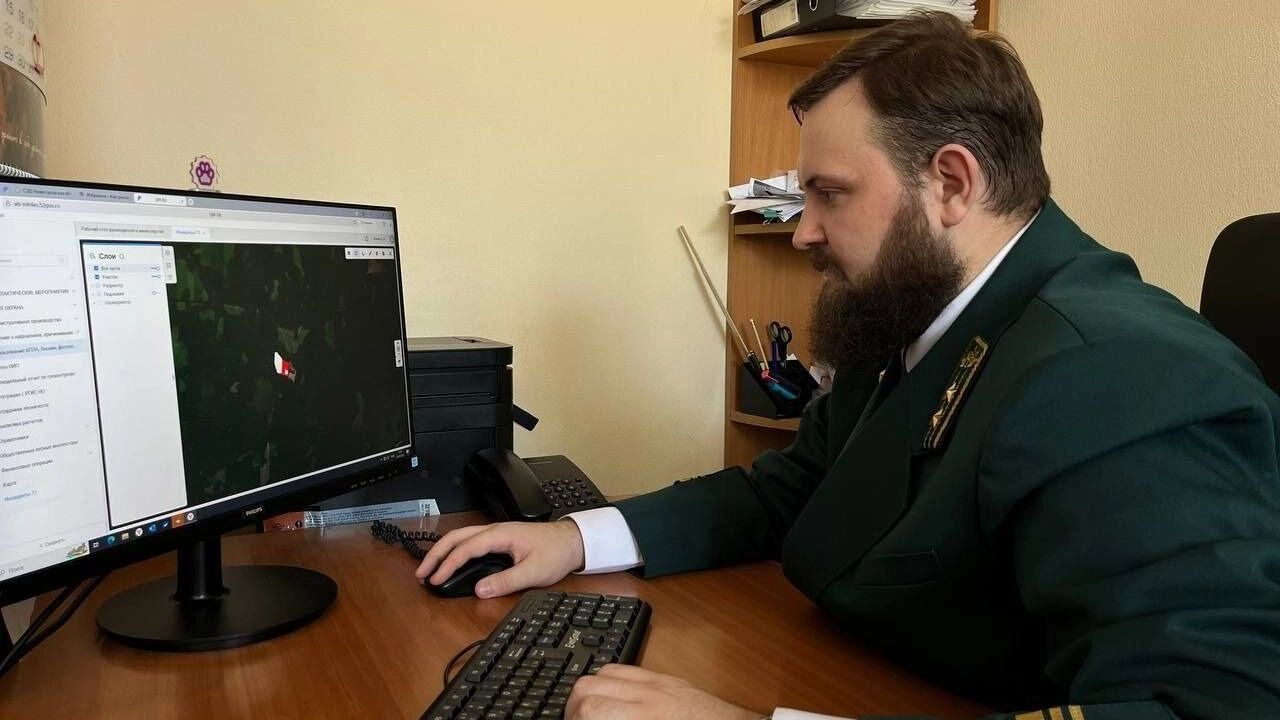

Ранее аналитическая обработка сведений, полученных посредством фото- и видеофиксации, велась ручными методами. Инспектор лично выезжал на местность и искал конкретный участок. Это, естественно, занимало время. Теперь же, благодаря ИИ, специалист будет получать точную геопривязку проблемных зон.

«Данные об изменениях на землях лесного фонда выявляются ИИ-средствами, работающими на основе информации, получаемой с низкоорбитальных спутников. Приход нейросетевых технологий в управление лесным хозяйством драматически меняет отрасль. Это прямо революция», — подчеркнул Поляков.

Также нейросеть поможет оптимизировать работу общественного транспорта в Нижнем Новгороде. ИИ будет анализировать ситуацию на 300 остановках: он подсчитает число ожидающих, выявит, в каких местах есть переизбыток пассажиров. После чего данные передадут диспетчерам, и они смогут скорректировать маршруты.

«Риски есть»

Потенциал искусственного интеллекта огромен, однако он несет в себе системные риски, рассказал NewsNN генеральный директор ООО «Альянс Перспективных Технологий» Ильдар Саттаров.

«Интеграция искусственного интеллекта в работу госорганов — уже не футуристический прогноз, а объективная реальность. Но системные риски требуют взвешенного и прагматичного подхода. Сегодня перед каждым руководителем стоит задача использовать ИИ как инструмент повышения эффективности, избегая при этом двух крайностей: наивного энтузиазма и консервативного скепсиса», — считает Саттаров.

Ключевым преимуществом ИИ для госсектора является способность обрабатывать колоссальные объемы неструктурированных данных, которые просто недоступны для человеческого анализа.

«Представим систему, которая в реальном времени анализирует тысячи обращений граждан со всей страны. Человек увидит лишь отдельные сообщения, в то время как ИИ способен выявить скрытую закономерность: например, рост числа жалоб на качество ЖКХ в конкретном муниципалитете, связанный с износом сетей, который еще не отражен в отчетах. Это позволяет перейти от реактивного управления (реагирования на кризис) к проактивному — предотвращению проблем на основе данных», — добавил собеседник NewsNN.

«Нет цепочки ответственности»

Однако такая сила новых технологий порождает фундаментальный правовой вопрос.

«Рассмотрим ситуацию: алгоритм, анализируя экономическую статистику, выдает некорректный прогноз, на основе которого принимается ошибочное бюджетное решение, ведущее к убыткам. Кто несет ответственность? Разработчик алгоритма, который не предусмотрел все переменные? Компания-интегратор, адаптировавшая систему под нужды ведомства? Или конечный пользователь-чиновник, который доверился выводам машины?» — отметил Саттаров.

Получается, что отсутствие четкой «цепочки ответственности» — главный барьер на пути безопасного внедрения ИИ. Поэтому сегодня основной задачей становится не столько технологическое развитие, сколько создание прозрачной правовой среды.

«России необходим собственный, суверенный подход к регулированию — не запретительный, а определяющий правила игры. Нужен федеральный закон, который бы четко прописывал статус ИИ-систем, стандарты их верификации и, самое главное, разграничивал ответственность между разработчиком, интегратором и пользователем. Только создав такой правовой фундамент, можно превратить ИИ из источника потенциальных рисков в мощный и контролируемый инструмент на службе государства», — убежден эксперт.

Также при использовании искусственного интеллекта существует риск утечки персональных данных, добавил директор по продукту Plevako.ai Евгений Гусев.

«Использование искусственного интеллекта органами власти действительно помогает повысить точность и скорость принятия решений. Однако автоматизация несет и риски: ошибки алгоритмов или сбои в данных могут привести к неверным решениям, а снижение человеческого контроля — к потере ответственности. Кроме того, важно учитывать вопросы безопасности и защиты персональных данных», — отметил Гусев в разговоре с NewsNN.