Faux appel téléphonique de Joe Biden : les élections américaines à l’épreuve des "deepvoices"

La vérification en bref :

- Les électeurs du New Hampshire ont reçu un message téléphonique censé provenir de Joe Biden, les invitant à ne pas aller voter.

- Des experts affirment que le message est un faux généré par l’intelligence artificielle.

- Il est très facile de cloner des voix grâce à des logiciels disponibles en ligne gratuitement.

- Des logiciels de détection des faux messages audio sont disponibles, mais ils ne sont pas toujours gratuits ou pas encore entièrement fiables.

Le détail de la vérification :

Le 23 janvier, les électeurs du New Hampshire ont confirmé sans surprise Joe Biden comme le candidat choisi lors de la primaire démocrate en vue de l'élection présidentielle de novembre.

Quelques jours avant le scrutin, le 21 janvier, certains électeurs ont reçu un appel délivrant un message de la part de Joe Biden. Bien que cela soit une pratique courante pendant les périodes électorales aux États-Unis, le contenu du message était inhabituel, incitant les destinataires à s'abstenir de voter lors des primaires démocrates. Le message téléphonique conseillait ainsi : "Réservez votre vote pour les élections de novembre."

NBC reports that NH voters are getting robocalls with a deepfake of Biden’s voice telling them to not vote tomorrow.

— Alex Thompson (@AlexThomp) January 22, 2024

“it’s important that you save your vote for the November election.”https://t.co/LAOKRtDanK pic.twitter.com/wzm0PcaN6H

Sur les écrans des personnes recevant l'appel, le numéro téléphonique d’une responsable démocrate du New Hampshire s’affichait. Celle-ci a décidé de porter plainte et une enquête a été ouverte le 22 janvier.

"Bien que la voix dans l'appel automatisé ressemble à la voix du président Biden, ce message semble être généré artificiellement sur la base de nos informations initiales", a déclaré le bureau du procureur général de l’État, ajoutant que "ces messages semblent être une tentative illégale de perturber l'élection primaire présidentielle du New Hampshire".

L'équipe de campagne de Donald Trump a assuré ne pas être impliquée dans cette affaire.

Un "deepvoice" visant Joe Biden

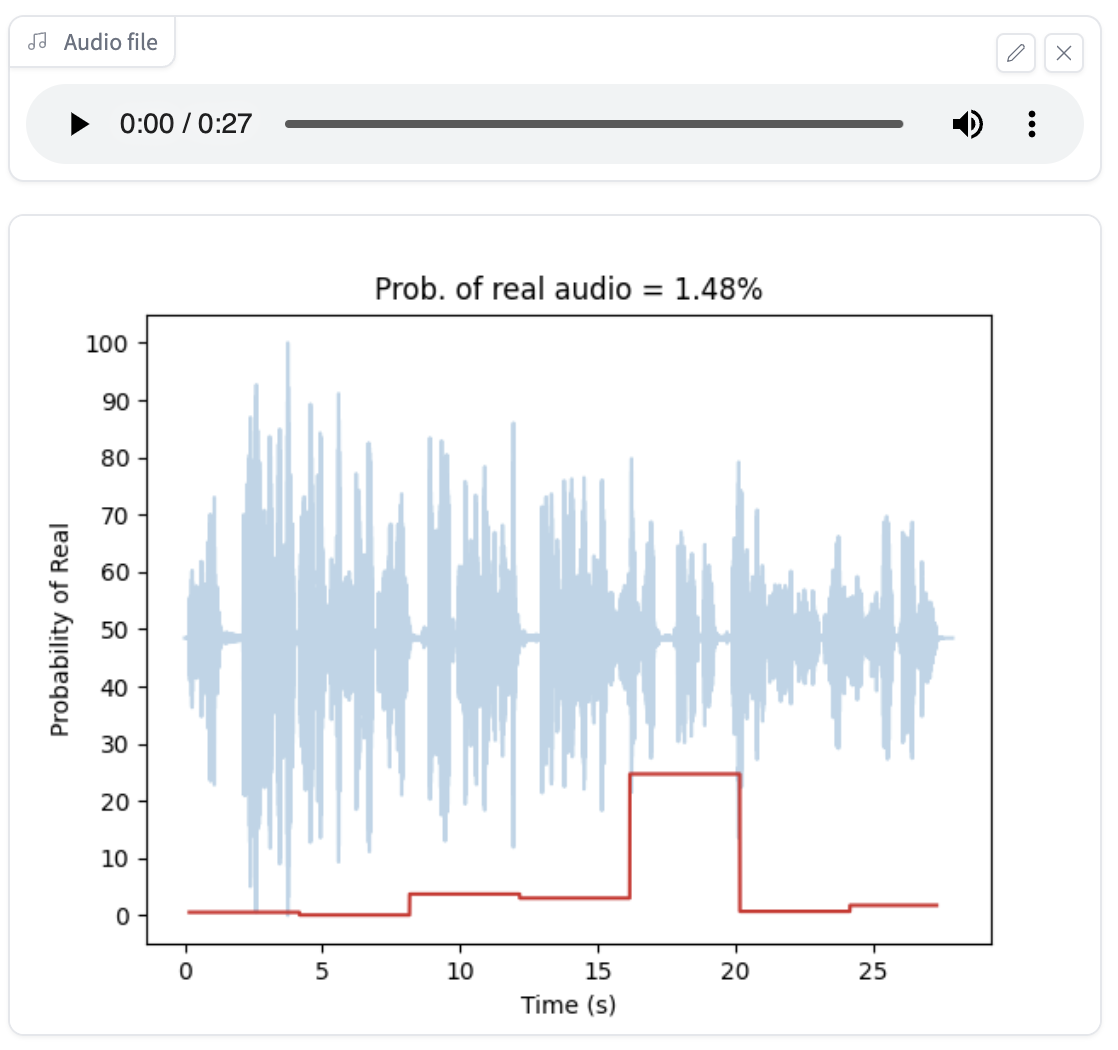

Manel Terraza, PDG et fondateur de Loccus.ai, un logiciel qui détecte des voix clonées par IA, affirme sur LinkedIn : "Nous identifions cet audio avec une très faible probabilité d'être réel, ce qui indique qu'il a été généré ou manipulé par l'IA."

Ces conclusions sont partagées par Ben Colman, responsable chez Reality Defender, une société spécialisée dans la détection de contenus générés par l’IA. "Tous les signes indiquent qu'il s'agit d'un 'deepfake'", explique-t-il à NBC News.

Les faux audios sont faciles à créer…

Contacté par notre rédaction, Ning Zhang, professeur assistant en sciences de l’informatique à l’université Washington de Saint-Louis, et spécialiste en intelligence artificielle, explique qu’un audio généré par l’intelligence artificielle peut avoir des conséquences néfastes, particulièrement en période d’élection, car ils peuvent être produits très facilement.

"Pour générer une vidéo, il faut créer une fausse image, puis un faux son, et enfin les synchroniser, tandis que des faux audios sont plus faciles à générer", explique Ning Zhang.

Il est par exemple possible de cloner une voix à l’aide de logiciels d’intelligence artificielle disponibles gratuitement en ligne.

… mais difficiles à identifier

"Il est plus facile de se rendre compte qu’une vidéo est fausse car on peut lire sur les lèvres et s'apercevoir que [le personnage] ne dit pas vraiment les mots qu’on entend. Le danger [d’un audio], c’est que c’est difficile à repérer", ajoute Ning Zhang. "Si je réponds au téléphone [et que je reçois un faux audio], je ne vais pas avoir le réflexe de le faire analyser à l’aide d’un détecteur. Même si c’est prouvé après que c’est un 'deepfake', cela peut être déjà trop tard."

Il existe des outils en ligne pour détecter les audios créés par l’intelligence artificielle, mais ceux-ci ne sont pas toujours fiables. Par exemple, nous avons testé le faux message de Joe Biden avec l’un d’entre eux, qui l’a identifié…comme une voix réelle.

Comment peut-on alors déterminer qu’un audio a été généré par une intelligence artificielle ?

Premier élément, "lorsqu’on utilise l’IA pour générer une voix, elle s’accompagne souvent d’un type d’artefact ou d’un bruit qui n’est pas naturel", explique Ning Zhang. Cela peut être un extrait d’une drôle de musique, par exemple.

"En général, la voix dans le monde réel suit souvent certaines règles physiques dans la nature, mais la voix artificielle ignore souvent ces règles", poursuit Ning Zhang.

Ning Zhang développe avec son équipe un mécanisme de détection des "deepfakes" audio en utilisant les techniques de la phonétique articulatoire. Plus précisément, ils estiment la disposition du conduit vocal humain lorsque la personne parle. Grâce à cela, il est possible de voir que les "deepfakes" modélisent souvent des voix qui demandent des gorges dont les dispositions anatomiques ne pourraient très probablement pas exister.

En dehors de ces programmes mis au point par les chercheurs, "le meilleur moyen est toujours de vérifier les sources officielles et de croiser les informations", conclut-il.

Inquiétudes des responsables américains

Aux États-Unis, les autorités craignent que les élections américaines ne soient bousculées par de fausses vidéos ou de faux messages vocaux de ce genre.

"Nous sommes à l'ère du 'deepfake' politique", a alerté Robert Weissman, président du groupe de défense des consommateurs Public Citizen. "Les décideurs politiques doivent se dépêcher de mettre en place des protections, sinon nous serons confrontés au chaos électoral."

Le secrétaire d’État David Scanlan a déclaré que ces appels "renforcent l’inquiétude nationale quant à l’effet de l’intelligence artificielle sur les campagnes".

Télécharger l'application